Grok4 登場!Baby Grok 也預告問世🌠

快訊:Gemini & ChatGPT得到奧林匹亞數學金牌、青少年把 AI 作為談心對象、Vibe Coding 工具 Kiro、研究助手 Jenni AI、情境工程

本期同樣提供 Podcast,如果你沒時間閱讀,可以邊聽邊吸收重點!

點上方播放鍵,收聽這期電子報,內容使用 NotekbookLM 語音生成。

Grok 4 號稱全球最智慧AI模型,核心亮點為原生工具使用、即時搜尋整合及多模態輸入 (涵蓋文字、圖片、語音)。它透過大規模強化學習,大幅提升推理與編碼能力。更強大的 Grok 4 Heavy 版本(一個月要300美金,是目前的 AI 價格天花板)採用多代理協作模式,在多項國際基準測試中表現卓越。其 API 具備 25.6 萬上下文視窗,語音模式更可即時分析影像。另外,馬斯克也在 X 宣布將推出兒童版 AI Grok,名為「Baby Grok」,重點將放在輔助兒童的學習,跟提供安全友善的聊天互動。

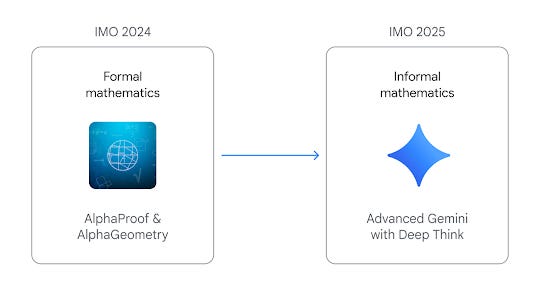

Gemini 2.5 Flash 的 Deep Think 深度思考模式與 OpenAI 最新大型語言模型,在2025年國際數學奧林匹亞(IMO)中,雙雙達到金牌標準,獲得滿分 42 分中的 35 分!這兩套 AI 展現出與全球前 10% 人類精英數學選手相當的複雜數學推理能力。Google 的升級版 Gemini 能直接用自然語言閱讀IMO題目並證明,其成績獲得官方認證,成為史上首個 IMO 金牌 AI。

OpenAI 的模型雖非專為數學設計,但強調通用推理,經獨立評審團評分也是達到金牌水準。儘管評測方式略有差異,兩大 AI 巨頭同時取得此成就,象徵 AI 在解決複雜非可驗證領域問題上的重大突破。未來將有望成為科學家的協作夥伴,協助解決更複雜的問題。

非營利組織 Common Sense Media 公布一項針對全美青少年的調查報告,發現近四分之三(72%)的青少年(13-17歲)曾使用 AI 聊天陪伴機器人,其中超過半數為常客。這邊的 AI 聊天陪伴機器人,可不是指任務導向 AI 如 ChatGPT 或 Claude;而是專門設計來陪伴使用者,可以深度對話的陪伴型聊天機器人,如 CHAI、Replika 或 Nomi 等。

青少年使用這些 AI 主要是出於娛樂、好奇心或尋求情感支持,甚至會跟 AI 討論嚴肅話題。然而,AI 聊天夥伴也帶來多重風險,怕會取代真實的人際連結,或是提供有害的建議、造成情緒依賴、隱私疑慮等潛在危險。因此 Common Sense Media 強烈建議 18 歲以下者不應使用 AI 伴侶。

小編也認同,青春期的少年少女應由專業且友善的輔導人員陪伴,引導他們走過慘綠時期的迷惘與不安,而不是貿然依賴仍具風險的 AI 工具。

Amazon 也參戰了!推出的 Kiro 是一款 AI 協助的開發工具,幫助工程師把靈感變成可實作的程式。主打要讓使用者進行「vibe coding」——靠直覺寫程式,Kiro 會幫你整理成清楚的需求、系統架構和任務,接著由 AI 協助實作。背後是 Claude 4 Sonnet 模型在運作,目前 Kiro 可免費試用喔。

Kiro 支援多種輸入方式,像是上傳 UI 設計圖或白板圖,也能自動生成文件、測試和優化程式碼。它有自動駕駛模式能幫忙處理大型任務,還能搭配 VS Code 使用。

Jenni AI 是一款幫助你讀文獻、寫論文的 AI 研究助理,目前有免費方案,全球已有超過 500 萬學術人士使用。它能自動補全句子、幫你寫作、改寫內容,還支援超過 1,700 種引用格式,幫你輕鬆管理參考文獻。

可以上傳 PDF,讓 AI 幫你摘要重點,甚至直接從資料生成內容。它也支援 30 種語言,能匯入 Zotero 和 Mendeley 資料,適合用在寫論文、文獻回顧或研究報告上。

過去,當我們與大型語言模型 (LLM) 互動時,最常聽到的是「Prompt Engineering (提示工程)」。提示工程的重點在於精心設計給 LLM 的文字指令,也就是您直接輸入給模型的簡短任務描述,希望透過巧妙的措辭來引導模型產生更好的回答。然而,隨著 AI 應用,特別是「AI 代理 (AI Agents)」的興起,單純的提示工程已經不足以應付複雜的任務。這兩週技術圈冒出了一個新名詞 - Context Engineering,直譯的話是情境工程或上下文工程。

科技專家 Andrej Karpathy (也就是創造出 Vibe Coding 這個詞的那位) 提出了一個很棒的比喻:「LLM 就像是一種新的作業系統,而它的『上下文視窗 (context window)』則像是電腦的『記憶體 (RAM)』,用來儲存模型處理過程所需的『工作記憶』」。但它的容量是有限的,Context Engineering 的目標是在正確的時機,以正確的格式提供正確的資訊和工具給 LLM,讓模型能夠順利完成任務。

例如你要建立一個很厲害的 AI 小助理 (AI agent),在呼叫 LLM 之前,就要主動收集各種相關資訊:例如,你的日曆資訊、過去郵件內容、聯絡人清單。有了這些資訊,LLM 在收到行程邀約時,才能幫你生成像這樣的回覆:「嘿發哥!我明天行程排滿了,要不要改星期四早上?」。但是要注意,提供的資訊也不是越多越好,一方面模型的記憶空間很有限,二來塞入過多不相關的資訊,反而會讓 AI「迷失方向」,最終導致性能下降、成本飆升、回應延遲,這種現象稱為「上下文失敗」(Context Failures)。

具體來說,Context Engineering 要考慮的面向有:

系統指令(System Prompt):每一支 AI 程式的「基本行為準則」,明定了 AI 應如何回應、遵守哪些規則。

外部知識(Retrieved Information):針對非一般性的特定問題,要求 AI 從外部文件、資料庫、API或知識圖譜中檢索相關資訊再回答,也就是 RAG 技術的應用。

外部工具:提供工具的操作說明,讓 AI 學會善用各種工具,有能力完成更多任務。

記憶系統(Memory Systems):有效儲存與使用者過去的互動、偏好或它學到的事實,讓 AI 能做到更「個性化」的服務。

動態狀態(State):AI會根據當前您、世界或多AI代理系統的即時情境變化來調整行為。

使用者請求(User Prompt):使用者對AI提出的問題或任務,也就是傳統提示工程的範疇。

以往跟 AI 互動只要善用提示詞就夠了,現在 AI 越來越厲害,要設計出好的應用,要考慮的面向也越來越多,想要讓 AI 無縫融入現在的工作流程和工作團隊,Context Engineering 就是不可或缺的必備技能。